Quanto è potente il nuovo GPT-4o?

Svelato l'arcano: il misterioso chatbot comparso su LMSYS Org, noto come "gpt2-chatbot" (ne abbiamo parlato qui e qui), non è altro che GPT-4o ("omni"), il nuovo modello multimodale di OpenAI. Lo ha confermato William Fedus, membro dello staff dell'azienda, in questo tweet.

Dall'annuncio di OpenAI, avvenuto nella diretta "Spring update" di lunedì, gli articoli e i post sui social hanno proliferato sul web fino a raggiungere quantità industriali. Per questo, il presente articolo non ripeterà i dettagli relativi al lancio e all'accessibilità del modello, ma si concentrerà piuttosto sulle sue capacità, cercando di quantificarne la potenza.

Per iniziare, GPT-4o è più intelligente, più efficiente e persino più economico del fratello maggiore GPT-4 Turbo, il che è già di per sé sorprendente. Inoltre, il modello sembra avere performance in lingue diverse dall'inglese, incluso l'italiano, fino a nove volte superiori rispetto al predecessore (dato già rilevato da Intellygenza col dialetto siciliano!).

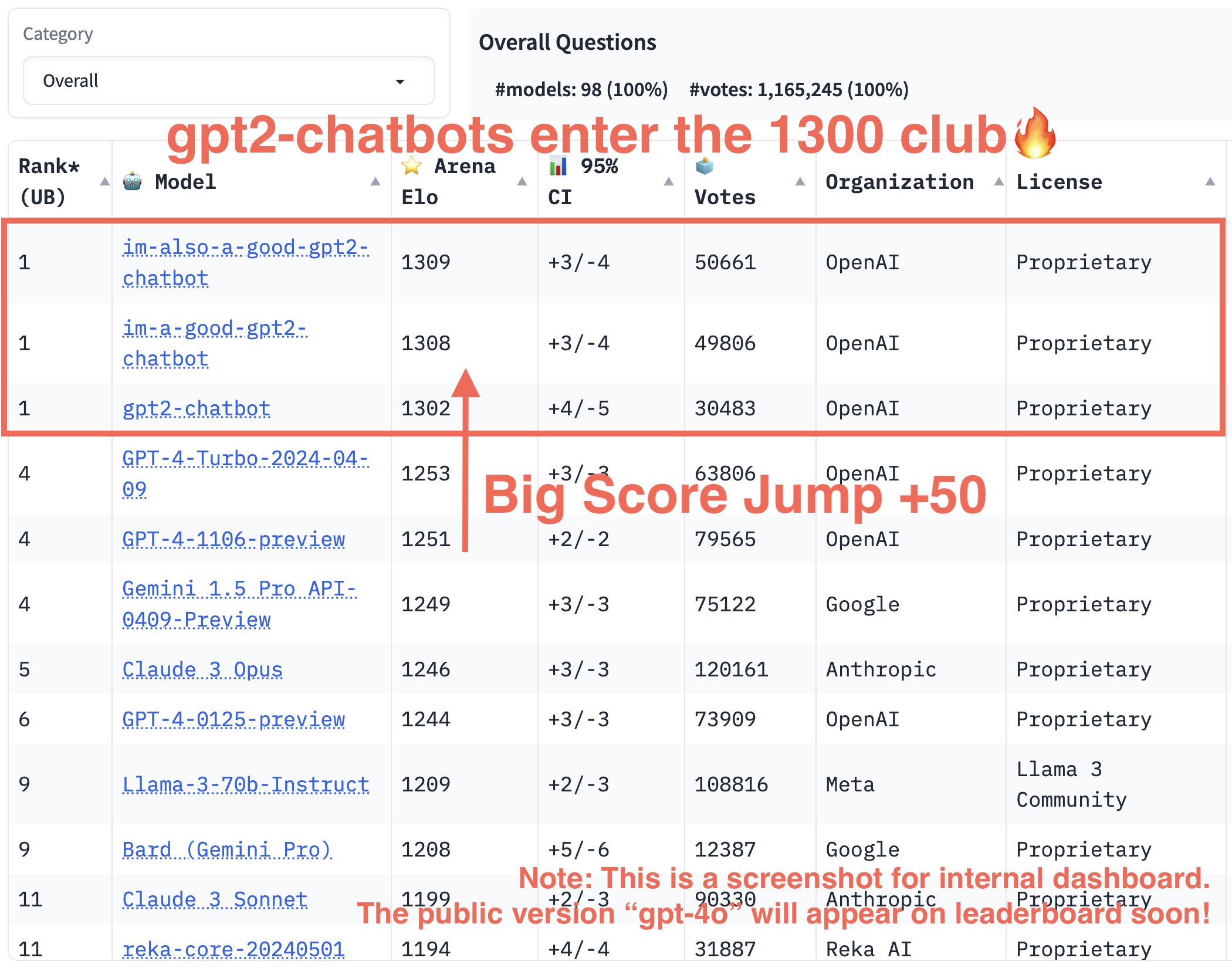

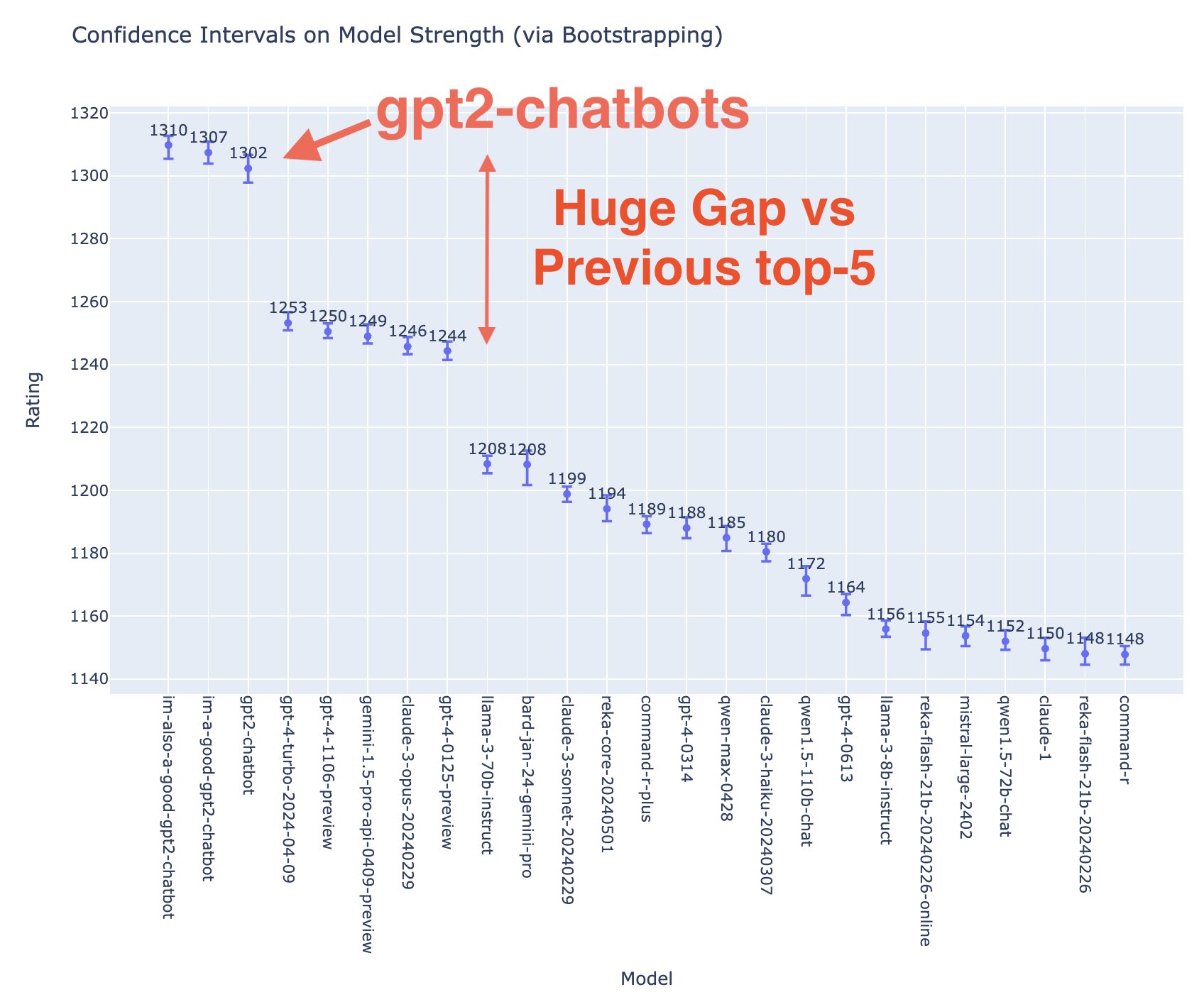

La potenza di questo modello è stata quantificata attraverso un sistema di valutazione basato sull'Elo, cioè un punteggio comparativo assegnato ai modelli in base ai feedback degli utenti di LMSYS Org. GPT-4o (denominato im-also-a-good-gpt2-chatbot sulla piattaforma) ha scalato ogni classifica dei chabot, a partire dalla categoria generale, in cui ha superato Claude 3 Opus, Gemini 1.5 Pro e GPT-4 Turbo fino a raggiungere un punteggio di 1310:

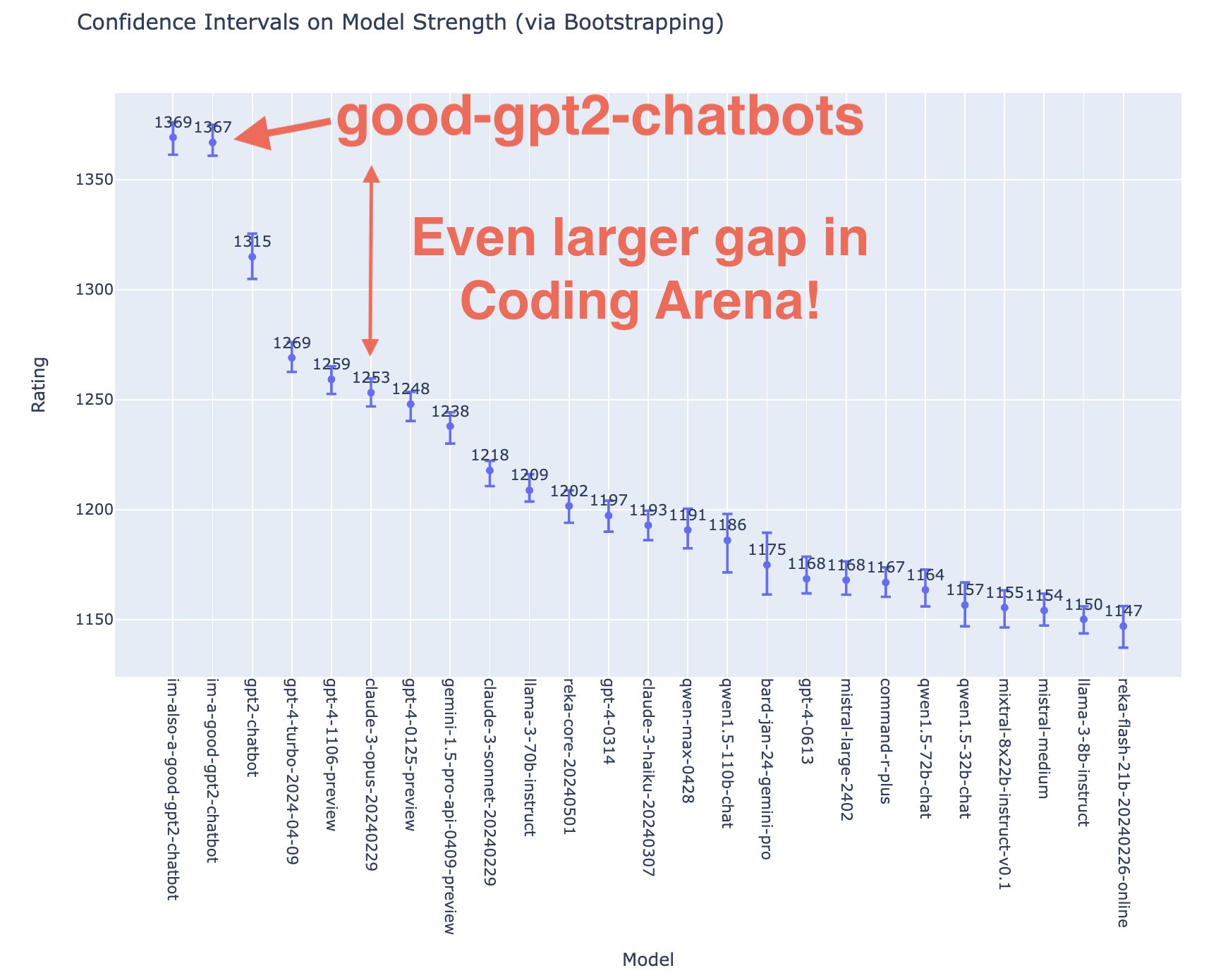

Un distacco di oltre 50 punti è incredibile, soprattutto se si considera che molte aziende faticano a guadagnare anche solo 10 punti. Nella categoria "Coding", poi, il modello surclassa GPT-4 Turbo sorpassandolo di 100 punti netti: 1269 vs 1369.

Ma la vera rivoluzione che rende OpenAI un passo più vicina all'AGI (Artificial General Intelligence) consiste nella natività multimediale del modello: GPT-4o, cioè, accetta come input qualsiasi combinazione di testo, audio, immagini e video e genera come output qualsiasi combinazione di testo, audio e immagini.

Questa caratteristica trasforma Chat GPT in un assistente vocale con cui è possibile interagire in modo spontaneo e naturale, quasi come fosse un essere umano. Infatti, il modello ha una voce decisamente poco robotica, può essere sarcastico e regolare l'emotività della propria intonazione. Numerosi sono gli articoli e i tweet che paragonano GPT-4o a Samantha, l'assistente virtuale del film Her.

Era possibile parlare con Chat GPT già da settembre 2023, attraverso la modalità "Voice", ma con latenze medie di 2,8 secondi (GPT-3.5) e 5,4 secondi (GPT-4). Questo si traduceva in conversazioni innaturali e macchinose, con chatbot incapaci di comprendere il tono dell'interlocutore, sentire i rumori di fondo, ridere, cantare o esprimere emozioni. Oltre a poter fare tutto questo, GPT-4o è in grado di rispondere agli input audio in appena 232 millisecondi, con una media di 320 millisecondi, avvicinandosi molto al tempo di risposta umano.

Le funzionalità di Chat GPT con GPT-4o sono quindi potenzialmente sterminate. OpenAI ne ha suggerite alcune su YouTube:

- Tradurre in tempo reale

- Risolvere problemi matematici

- Giocare a sasso-carta-forbici

- Conversare e cantare con due GPT-4o

- Fornire un servizio di assistenza clienti

- Includere Chat GPT in una riunione

- Testare la propria comicità

Fonti e approfondimenti:

OpenAI

Blog di Sam Altman

Tom's Guide

Ben's Bites

LMSYS Org