Quanto costa addestrare un modello di AI?

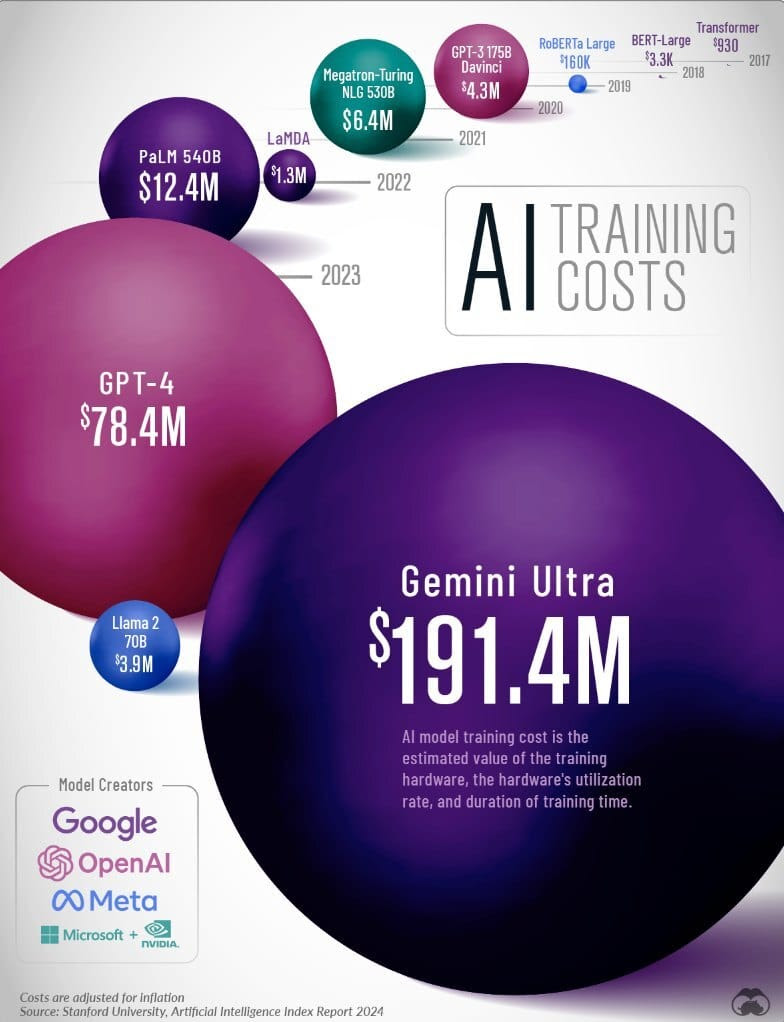

Addestrare un LLM (Large Language Model) sta diventando sempre più costoso, come rilevato dall'Artificial Intelligence Index Report 2024 dell'Università di Stanford ed illustrato dall'infografica di Visual Capitalist.

I costi di addestramento

Negli ultimi anni, i costi di addestramento dei modelli dell'AI sono aumentati in maniera esponenziale. Ad esempio, l'addestramento di GPT-4 di OpenAI nel 2023 ha raggiunto i 78,4 milioni di dollari, una cifra vertiginosa rispetto ai "soli" 12,4 milioni di dollari spesi da Google per il modello PaLM (540B) nel 2022. Questi numeri sono impressionanti se confrontati con i 930 dollari spesi nel 2017 per addestrare il Transformer di Google, il modello che ha posto le basi per molti degli LLM utilizzati oggi.

L'infografica di Visual Capitalist mostra chiaramente come i costi di addestramento, aggiustati per l'inflazione, siano saliti alle stelle:

- 2017: Transformer di Google - $930

- 2018: BERT-Large di Google - $3,288

- 2019: RoBERTa Large di Meta - $160,018

- 2020: GPT-3 175B (davinci) di OpenAI - $4,324,883

- 2021: Megatron-Turing NLG 530B di Microsoft/NVIDIA - $6,405,653

- 2022: LaMDA di Google - $1,319,586

- 2022: PaLM (540B) di Google - $12,389,056

- 2023: GPT-4 di OpenAI - $78,352,034

- 2023: Llama 2 70B di Meta - $3,931,897

- 2023: Gemini Ultra di Google - $191,400,000

Il modello più costoso di tutti, Gemini Ultra di Google, ha raggiunto la cifra stratosferica di 191,4 milioni di dollari, superando di gran lunga i costi di GPT-4.

Come vengono determinati i costi di addestramento

I costi di addestramento dei modelli di AI sono influenzati da diversi fattori chiave. L'Università di Stanford ha collaborato con Epoch AI, la società di ricerca indipendente nel settore AI, per stimare i costi sulla base ai prezzi dei servizi di cloud computing. Tra i fattori considerati sono presenti la durata dell'addestramento, il tasso di utilizzo e il valore dell'hardware utilizzato.

L'addestramento futuro

Con l'aumento dei costi, le aziende AI sono costrette a cercare nuove soluzioni per rendere più efficiente l'addestramento dei modelli linguistici. Tra queste soluzioni vi sono la creazione di modelli più piccoli, progettati per eseguire compiti specifici, e l'utilizzo di dati sintetici per alimentare piccoli sistemi di AI specializzati in un settore specifico (si veda, a tal proposito, la possibile carenza di dati che si avrà in futuro). Tuttavia, nonostante questi tentativi, non si è ancora arrivati ad un vero e proprio punto di svolta capace di aggirare il problema dei costi. L'utilizzo di dati sintetici, infatti, ha mostrato alcuni limiti: i modelli di IA che utilizzano questi dati hanno prodotto in più di un caso risultati privi di senso, portando a quello che viene definito "collasso del modello".

Fonti:

Visual Capitalist

Artificial Intelligence Index Report 2024