OpenAI o3 e o4-mini: i primi modelli di ragionamento visuale

I nuovi modelli di OpenAI combinano il ragionamento avanzato con l'elaborazione delle immagini e l'uso integrato di strumenti. Ma attenzione alle allucinazioni.

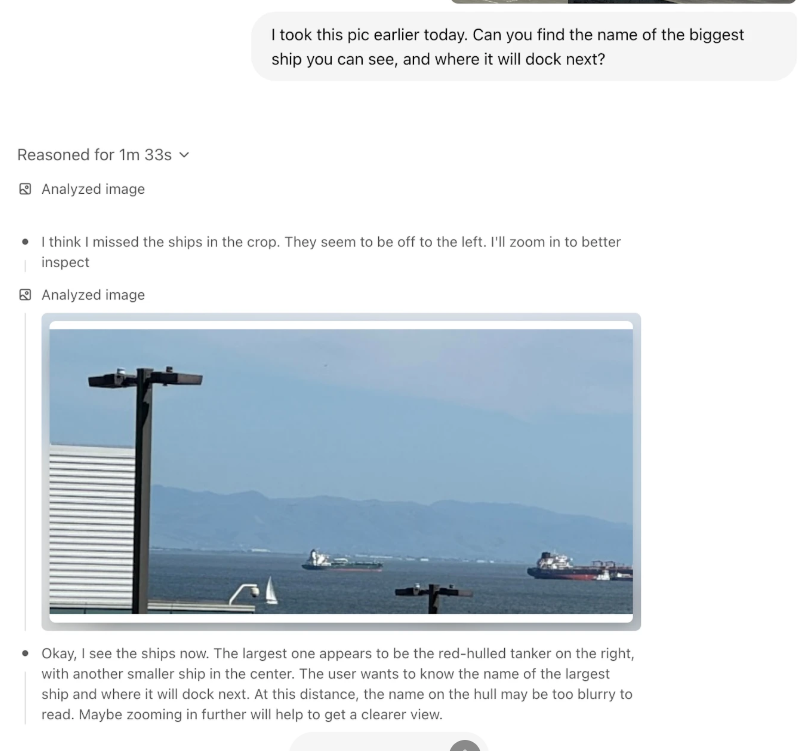

Arriva il pensiero visuale

Rilasciati il 16 aprile, o3 e o4-mini di OpenAI non si limitano a "visualizzare" un'immagine, ma integrano il contenuto visivo direttamente nel loro processo di ragionamento. Tutto ciò si traduce nella capacità di manipolare le immagini durante l'elaborazione delle risposte: possono zoomare, ruotare, ritagliare e trasformare le immagini. Se, per esempio, caricate la foto di un quaderno con una frase scritta, scattata da lontano e con il quaderno capovolto, l'AI effettuerà automaticamente lo zoom, ritaglierà la parte rilevante e ruoterà l'immagine per leggere correttamente il testo.

Fonte: OpenAI

Fonte: OpenAIo3 e o4-mini: qual è la differenza?

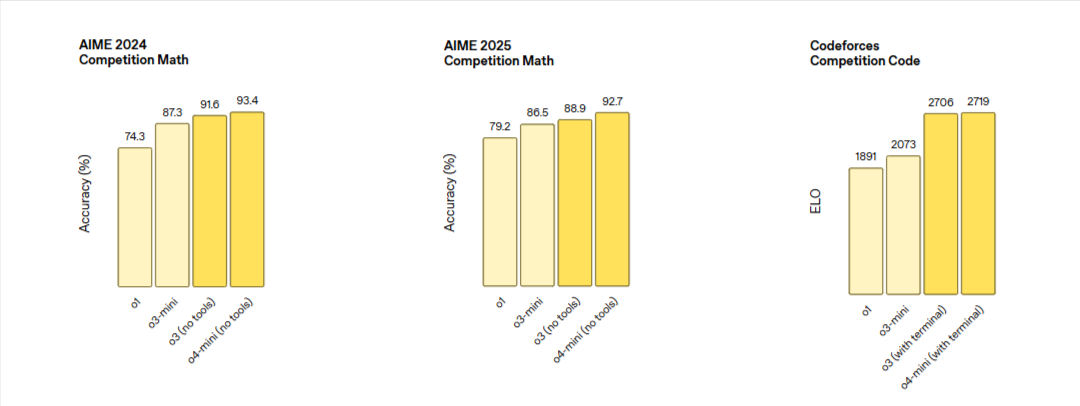

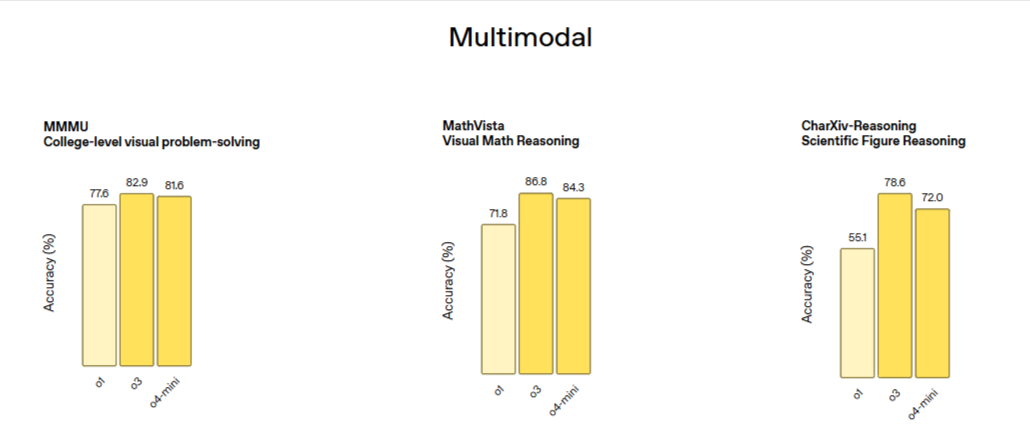

In occasione del lancio di o3-mini e o3-mini-high , OpenAI aveva preannunciato anche o3, inizialmente previsto per febbraio 2025. Nonostante il ritardo, o3 è arrivato insieme a o4-mini ed è adesso il nuovo modello di punta dell'azienda. Eccelle in compiti di programmazione, matematica avanzata e analisi scientifiche. Secondo i test interni di OpenAI, o3 ha registrato un miglioramento del 25% rispetto al suo predecessore o1 nei test visivi.

OpenAI o4-mini è invece la versione ottimizzata per velocità ed efficienza. Offre prestazioni notevoli considerando le sue dimensioni ridotte ed è particolarmente efficace per attività quotidiane che richiedono risposte rapide. Disponibile anche nella variante "o4-mini-high" per un po' più di potenza di elaborazione.

La scelta tra i due dipende dalle vostre esigenze: o3 per problemi complessi che richiedono ragionamento approfondito, o4-mini per risposte veloci e a basso costo.

Fonte: OpenAI

Fonte: OpenAI Fonte: OpenAI

Fonte: OpenAIL'uso integrato degli strumenti

Entrambi i modelli possono utilizzare autonomamente tutti gli strumenti disponibili in ChatGPT:

- Ricerca web: possono cercare informazioni aggiornate oltre la loro conoscenza di base

- Analisi di file: elaborazione di documenti caricati dagli utenti

- Interprete Python: per analisi dati e calcoli complessi

- Generazione di immagini: creazione di contenuti visivi

Questi modelli sono stati addestrati non solo a usare gli strumenti, ma anche a ragionare su quando utilizzarli. Possono concatenare più chiamate agli strumenti in modo strategico per risolvere problemi complessi.

Attenzione alle allucinazioni

Nonostante i progressi, c'è anche un passo indietro: secondo test interni di OpenAI e verifiche di laboratori indipendenti come Transluce, i nuovi modelli presentano un tasso di allucinazioni più elevato rispetto ai predecessori.

o3 ha mostrato allucinazioni nel 33% delle domande su PersonQA, il benchmark interno di OpenAI per misurare l'accuratezza delle conoscenze sulle persone - circa il doppio rispetto a o1 (16%) e o3-mini (14,8%). o4-mini ha fatto anche peggio, allucinando dati nel 48% delle risposte.

Neil Chowdhury di Transluce, ex dipendente di OpenAI, suggerisce che il tipo di apprendimento per rinforzo utilizzato per i modelli della serie "o" potrebbe amplificare problemi solitamente mitigati nelle fasi di post-addestramento.

Una possibile soluzione per questo problema è l'integrazione con la ricerca online, che su GPT-4o ha portato a un'accuratezza del 90% su SimpleQA, altro benchmark di OpenAI.

Limitazioni da considerare

Prima di affidarvi completamente a questi modelli, tenete a mente alcune limitazioni:

- Immagini specialistiche: potrebbero avere difficoltà con immagini altamente tecniche come un ECG o una micrografia elettronica

- Immagini di bassa qualità: foto estremamente sfocate o pixelate possono risultare problematiche anche per questi modelli

- Rischi di bias: le foto usate per l'addestramento possono contenere bias umani

- Privacy: fate attenzione a non includere involontariamente informazioni sensibili nelle immagini caricate

Chi può accedere a o3 e o4-mini?

Gli utenti di ChatGPT Plus, Pro e Team vedranno o3, o4-mini e o4-mini-high nel menù dei modelli, al posto di o1, o3-mini e o3-mini-high. Gli utenti Enterprise ed Edu vi avranno accesso tra una settimana, mentre gli utenti gratuiti potranno provare o4-mini selezionando la funzione "Think". OpenAI prevede di rilasciare o3-pro con supporto completo agli strumenti nelle prossime settimane, ed entrambi i modelli o3 e o4-mini sono ora disponibili per gli sviluppatori tramite API.

Il futuro del ragionamento visuale

OpenAI ha indicato che, sebbene GPT-5 sia in arrivo, i modelli o3 e o4-mini continueranno a ricevere miglioramenti in sicurezza e precisione. Tra questi:

- Stringhe di codice migliori con visibilità più profonda in ogni passaggio del ragionamento

- Incrementi di velocità per o4-mini senza cambi di nome

- "Pensionamento" di o1 con migrazione degli utenti a o3 per sfruttare le capacità visive

Grazie per il tuo tempo. Buona Pasqua dallo staff di Intellygenza 💡